GOC AI Console

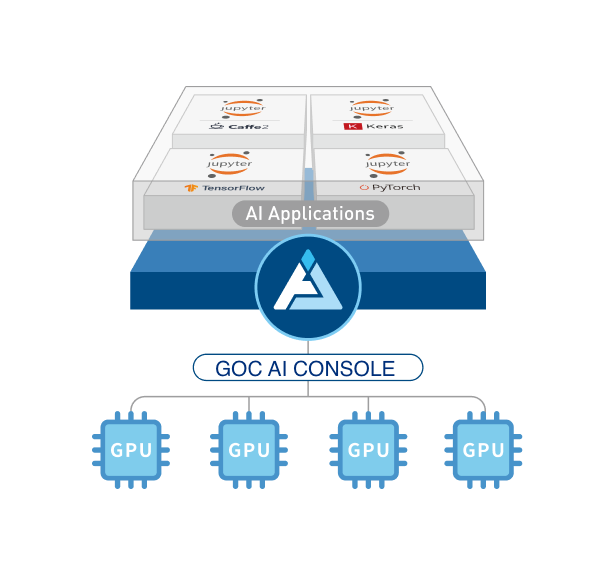

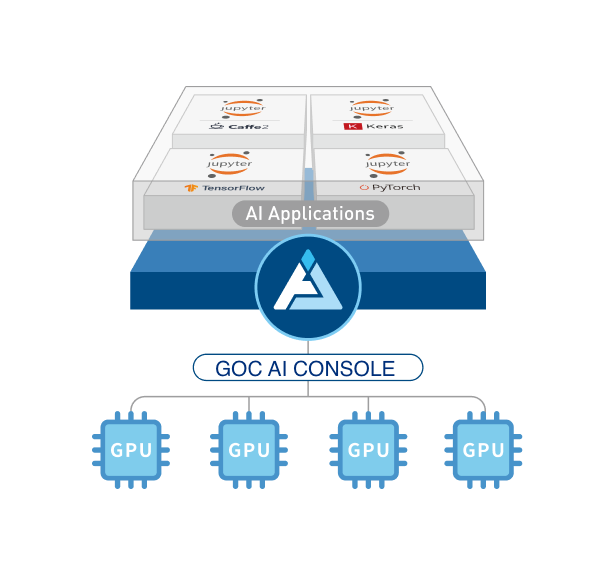

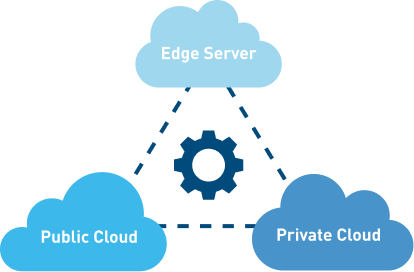

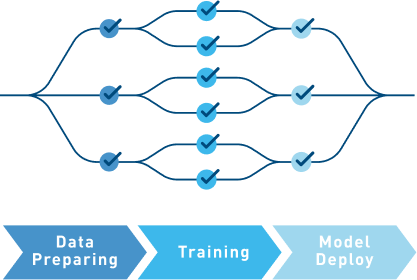

透過 GOC AI Console 打造出便利企業組織進行跨單位 AI 專案協作的 GPU 管理節點,將底層運算架構建置化繁為簡,進而能夠將時間與人力資源專注投入在核心演算法上,協助企業更有效率地從海量資料挖掘出更好的商機。

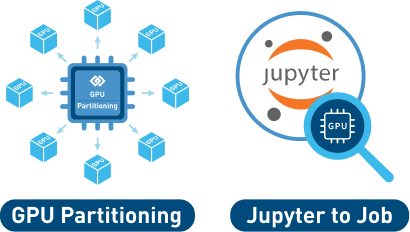

資料科學家與開發人員可透過 GOC AI Console 使用者服務入口,便利地快速開啟大量預載大數據與 AI 工具的運算叢集環境,搭配獨家 GPU Partitioning 技術,將 GPU 使用率達到極致 !

透過 GOC AI Console 打造出便利企業組織進行跨單位 AI 專案協作的 GPU 管理節點,將底層運算架構建置化繁為簡,進而能夠將時間與人力資源專注投入在核心演算法上,協助企業更有效率地從海量資料挖掘出更好的商機。

資料科學家與開發人員可透過 GOC AI Console 使用者服務入口,便利地快速開啟大量預載大數據與 AI 工具的運算叢集環境,搭配獨家 GPU Partitioning 技術,將 GPU 使用率達到極致 !

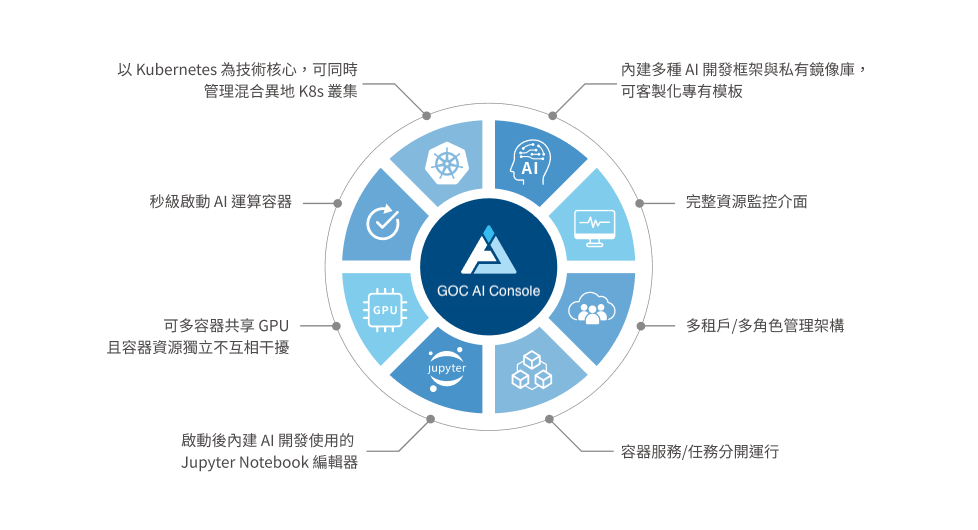

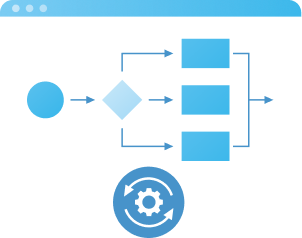

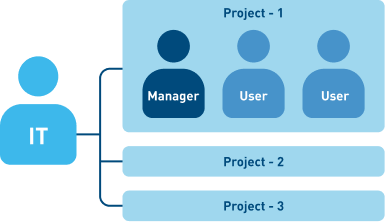

GOC AI Console 是專門為多用戶、多團隊、多種工作負載協同共享而設計的人工智慧管理平台。

在 Kubernetes 中,最大限度地利用 GPU 資源。進行深度學習訓練和推論預測讓企業從中獲得價值。

具有自動化特性和功能,解放 IT 架構師和資料科學家人工安排調度管理的窘境。

使用高效能的GPU環境進行開發,大量節省模型訓練時間,進一步提升開發效率。

使用者無須修改任何程式,就可以使用分割後的GPU。

有能力控制容器資源的隔離獨立,保證個別容器的資源,不受其他容器的干擾。

使用者可規範的最小/最大QoS. 還可以彈性地自動調大GPU額度,也減少人員管理 overhead。

Kubernetes可以執行同時更多機器學習容器,減少搶佔,更減少排隊時間。

總利用率可接近個別容器利用率之和。

透過 AI Console 所創建的 Jupyter 開發服務,均內建 Jupyter to Job 這個外掛功能,可透過 Jupyter 派送 GPU 任務,並可瀏覽任務日誌,有助於除錯與追蹤。

「我們的需求是讓 GPU 資源公平分配,且方便管理。在GOC AI Console系統導入後,讓 AI 人工智慧教學單純化,師生可專注在 AI 模型的建立與訓練,不用花費大量時間在系統操作面上,可加快踏入 AI 人工智慧與機器學習的應用領域。」

更多內容...德明財經科技大學 電算中心